Web日志發掘是指采取數據發掘技術,對站點用戶訪問Web服務器進程中產生的日志數據進行分析處理,從而發現Web用戶的訪問模式和興趣愛好等,這些信息對站點建設潛伏有用的可理解的未知信息和知識,用于分析站點的被訪問情況,輔助站點管理和決策支持等。

1、以改進web站點設計為目標,通過發掘用戶聚類和用戶的頻繁訪問路徑,修改站點的頁面之間的鏈接關系,以適利用戶的訪問習慣,并且同時為用戶提供有針對性的電子商務活動和個性化的信息服務,利用信息推拉技術構建智能化Web站點。

2、以分析Web站點性能為目標,主要從統計學的角度,對日志數據項進行粗略的統計分析,得到用戶頻繁訪問頁、單位時間的訪問數、訪問數量隨時間散布圖等。現有的絕大多數的Web日志分析工具都屬于此類。

3、以理解用戶意圖為目標,主要是通過與用戶交互的進程搜集用戶的信息,Web服務器根據這些信息對用戶要求的頁面進行裁剪,為用戶返回定制的頁面,其目的就是提高用戶的滿意度和提供個性化的服務。

網站分析數據主要有3種搜集方式:Web日志、JavaScript標記和包嗅探器。

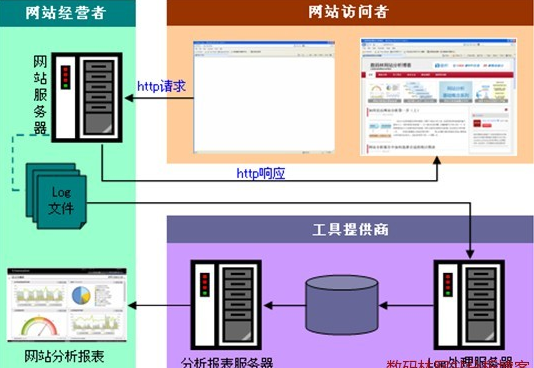

1. Web日志

web日志處理流程:

從上圖可以看出網站分析數據的搜集從網站訪問者輸入URL向網站服務器發出http要求就開始了。網站服務器接收到要求后會在自己的Log文件中追加1條記錄,記錄內容包括:遠程主機名(或是IP地址)、登錄名、登錄全名、發要求的日期、發要求的時間、要求的詳細(包括要求的方法、地址、協議)、要求返回的狀態、要求文檔的大小。隨后網站服務器將頁面返回到訪問者的閱讀器內得以展現。

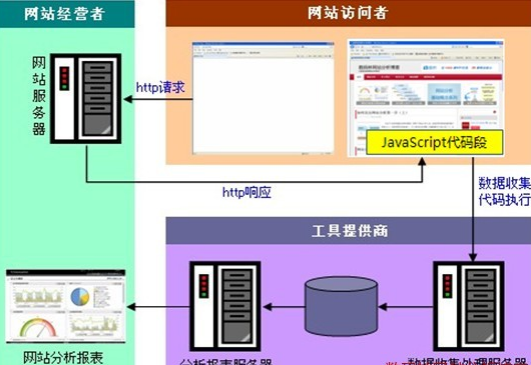

2. JavaScript標記

JavaScript標記處理流程:

上圖所示JavaScript標記同Web日志搜集數據1樣,從網站訪問者發出http要求開始。不同的是,JavaScript標記返回給訪問者的網頁代碼中會包括1段特殊的JavaScript代碼,當頁面展現的同時這段代碼也得以履行。這段代碼會從訪問者的Cookie中獲得詳細信息(訪問時間、閱讀器信息、工具廠商賦予當前訪問者的userID等)并發送到工具商的數據搜集服務器。數據搜集服務器對搜集到的數據處理后存入數據庫中。網站經營人員通過訪問分析報表系統查看這些數據。

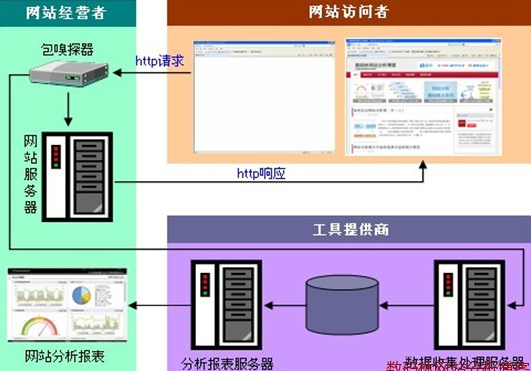

3. 包嗅探器

通過包嗅探器搜集分析的流程:

上圖可以看出網站訪問者發出的要求到達網站服務器之前,會先經過包嗅探器,然后包嗅探器才會將要求發送到網站服務器。包嗅探器搜集到的數據經過工具廠商的處理服務器后存入數據庫。隨后網站經營人員就能夠通過分析報表系統看到這些數據。

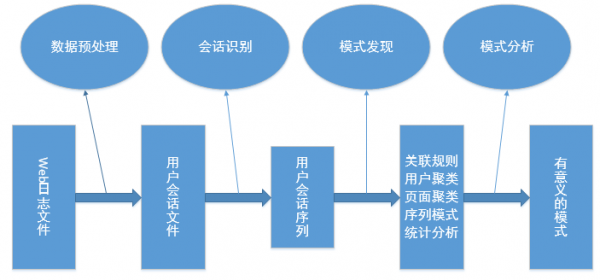

整體流程參考下圖:

1、數據預處理階段

根據發掘的目的,對原始Web日志文件中的數據進行提取、分解、合并、最后轉換為用戶會話文件。該階段是Web訪問信息發掘最關鍵的階段,數據預處理包括:關于用戶訪問信息的預處理、關于內容和結構的預處理。

2、會話辨認階段

該階段本是屬于數據預處理階段中的1部份,這里將其劃分成單獨的1個階段,是由于把用戶會話文件劃分成的1組組用戶會話序列將直接用于發掘算法,它的精準度直接決定了發掘結果的好壞,是發掘進程中最重要的階段。

3、模式發現階段

模式發現是應用各種方法和技術從Web同志數據中發掘和發現用戶使用Web的各種潛伏的規律和模式。模式發現使用的算法和方法不單單來自數據發掘領域,還包括機器學習、統計學和模式辨認等其他專業領域。

模式發現的主要技術有:統計分析(statistical analysis)、關聯規則(association rules)、聚類(clustering)、歸類(classification)、序列模式(sequential patterns)、依賴關系(dependency)。

(1)統計分析(statistical analysis):經常使用的統計技術有:貝葉斯定理、預測回歸、對數回歸、對數-線性回歸等。可用來分析網頁的訪問頻率,網頁的訪問時間、訪問路徑。可用于系統性能分析、發現安全漏洞、為網站修改、市場決策提供支持。

(2)關聯規則(association rules):關聯規則是最基本的發掘技術,同時也是WUM最經常使用的方法。在WUM中常經常使用在被訪問的網頁中,這有益于優化網站組織、網站設計者、網站內容管理者和市場分析,通過市場分析可以知道哪些商品被頻繁購買,哪些顧客是潛伏顧客。

(3)聚類(clustering):聚類技術是在海量數據中尋覓彼此相似對象組,這些數據基于距離函數求出對象組之間的相似度。在WUM中可以把具有相似模式的用戶分成組,可以用于電子商務中市場分片和為用戶提供個性化服務。

(4)歸類(classification):歸類技術主要用處是將用戶資料歸入某1特定類中,它與機器學習關系很緊密。可以用的技術有:決策樹(decision tree)、K-最近鄰居、Na?ve Bayesian classifiers、支持向量機(support vector machines)。

(5)序列模式(sequential patterns):給定1個由不同序列組成的集合,其中,每一個序列由不同的元素按順序有序排列,每一個元素由不同項目組成,同時給定1個用戶指定的最小支持度閾值,序列模式發掘就是找出所有的頻繁子序列,即子序列在序列集中的出現頻率不低于用戶指定的最小支持度閾值。

(6)依賴關系(dependency):1個依賴關系存在于兩個元素之間,如果1個元素A的值可以推出另外一個元素B的值,則B依賴于A。

4、模式分析階段

模式分析是Web使用發掘最后1步,主要目的是過濾模式發現階段產生的規則和模式,去除那些無用的模式,并把發現的模式通過1定的方法直觀的表現出來。由于Web使用發掘在大多數情況下屬于無偏向學習,有可能發掘出所有的模式和規則,所以不能排除其中有些模式是常識性的,普通的或終究用戶不感興趣的,故必須采取模式分析的方法使得發掘出來的規則和知識具有可讀性和終究可理解性。常見的模式分析方法有圖形和可視化技術、數據庫查詢機制、數理統計和可用性分析等。

搜集的數據主要包括:

全局UUID、訪問日期、訪問時間、生成日志項的服務器的IP地址、客戶端試圖履行的操作、客戶端訪問的服務器資源、客戶端嘗試履行的查詢、客戶端連接到的端口號、訪問服務器的已驗證用戶名稱、發送服務器資源要求的客戶端IP地址、客戶端使用的操作系統、閱讀器等信息、操作的狀態碼(200等)、子狀態、用Windows@使用的術語表示的操作的狀態、點擊次數。

用戶辨認

對網站的運營者來講,如何能夠高效精確的辨認用戶非常關鍵,這會對網站運營帶來極大的幫助,如定向推薦等。

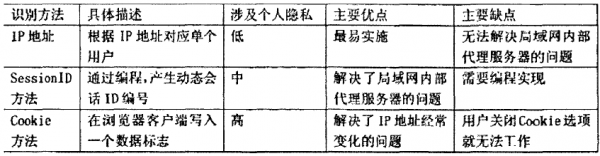

用戶辨認方法以下:

數據搜集到服務器以后,根據數據量可以斟酌將數據存儲在hadoop的HDFS中。

如果不熟習HDFS,可以參考:

http://www.niubua.com/?p=1107

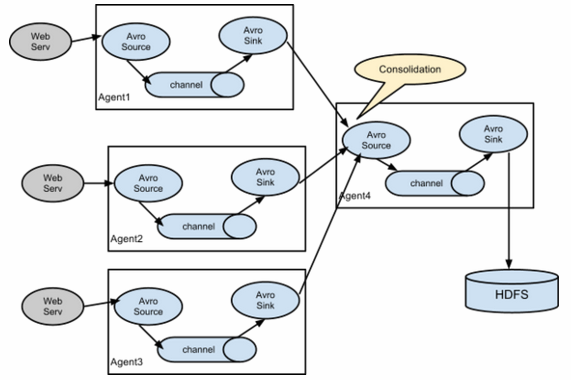

在現在的企業中,1般情況下都是多臺服務器生成日志,日志包括nginx生成的,也包括在程序中使用log4j生成的自定義格式的。

通常的架構以下圖:

nginx默許的日志格式以下:

222.68.172.190 - - [18/Sep/2013:06:49:57 +0000] "GET /images/my.jpg HTTP/1.1" 200 19939 "http://www.angularjs.cn/A00n" "Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/29.0.1547.66 Safari/537.36"

變量的解釋以下: