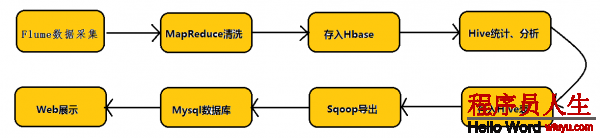

在具體介紹本文內(nèi)容之前,先給大家看1下Hadoop業(yè)務(wù)的整體開發(fā)流程:

從Hadoop的業(yè)務(wù)開發(fā)流程圖中可以看出,在大數(shù)據(jù)的業(yè)務(wù)處理進(jìn)程中,對(duì)數(shù)據(jù)的收集是10分重要的1步,也是不可避免的1步,從而引出我們本文的主角—Flume。本文將圍繞Flume的架構(gòu)、Flume的利用(日志收集)進(jìn)行詳細(xì)的介紹。

(1)Flume架構(gòu)介紹

1、Flume的概念

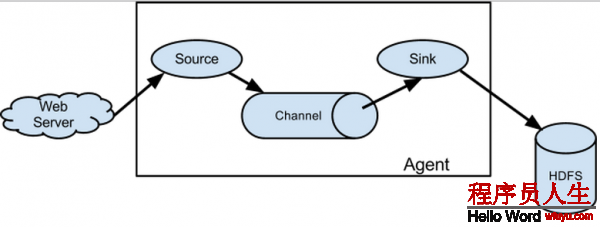

flume是散布式的日志搜集系統(tǒng),它將各個(gè)服務(wù)器中的數(shù)據(jù)搜集起來(lái)并送到指定的地方去,比如說(shuō)送到圖中的HDFS,簡(jiǎn)單來(lái)講flume就是搜集日志的。

2、Event的概念

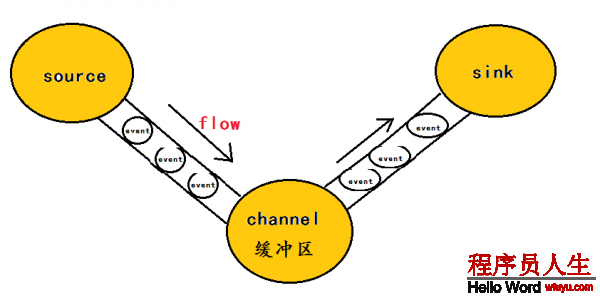

在這里有必要先介紹1下flume中event的相干概念:flume的核心是把數(shù)據(jù)從數(shù)據(jù)源(source)搜集過(guò)來(lái),在將搜集到的數(shù)據(jù)送到指定的目的地(sink)。為了保證輸送的進(jìn)程1定成功,在送到目的地(sink)之前,會(huì)先緩存數(shù)據(jù)(channel),待數(shù)據(jù)真正到達(dá)目的地(sink)后,flume在刪除自己緩存的數(shù)據(jù)。

在全部數(shù)據(jù)的傳輸?shù)倪M(jìn)程中,活動(dòng)的是event,即事務(wù)保證是在event級(jí)別進(jìn)行的。那末甚么是event呢?—–event將傳輸?shù)臄?shù)據(jù)進(jìn)行封裝,是flume傳輸數(shù)據(jù)的基本單位,如果是文本文件,通常是1行記錄,event也是事務(wù)的基本單位。event從source,流向channel,再到sink,本身為1個(gè)字節(jié)數(shù)組,并可攜帶headers(頭信息)信息。event代表著1個(gè)數(shù)據(jù)的最小完全單元,從外部數(shù)據(jù)源來(lái),向外部的目的地去。

為了方便大家理解,給出1張event的數(shù)據(jù)流向圖:

1個(gè)完全的event包括:event headers、event body、event信息(即文本文件中的單行記錄),以下所以:

其中event信息就是flume搜集到的日記記錄。

3、flume架構(gòu)介紹

flume之所以這么奇異,是源于它本身的1個(gè)設(shè)計(jì),這個(gè)設(shè)計(jì)就是agent,agent本身是1個(gè)java進(jìn)程,運(yùn)行在日志搜集節(jié)點(diǎn)—所謂日志搜集節(jié)點(diǎn)就是服務(wù)器節(jié)點(diǎn)。

agent里面包括3個(gè)核心的組件:source—->channel—–>sink,類似生產(chǎn)者、倉(cāng)庫(kù)、消費(fèi)者的架構(gòu)。

source:source組件是專門用來(lái)搜集數(shù)據(jù)的,可以處理各種類型、各種格式的日志數(shù)據(jù),包括avro、thrift、exec、jms、spooling directory、netcat、sequence generator、syslog、http、legacy、自定義。

channel:source組件把數(shù)據(jù)搜集來(lái)以后,臨時(shí)寄存在channel中,即channel組件在agent中是專門用來(lái)寄存臨時(shí)數(shù)據(jù)的——對(duì)收集到的數(shù)據(jù)進(jìn)行簡(jiǎn)單的緩存,可以寄存在memory、jdbc、file等等。

sink:sink組件是用于把數(shù)據(jù)發(fā)送到目的地的組件,目的地包括hdfs、logger、avro、thrift、ipc、file、null、hbase、solr、自定義。

4、flume的運(yùn)行機(jī)制

flume的核心就是1個(gè)agent,這個(gè)agent對(duì)外有兩個(gè)進(jìn)行交互的地方,1個(gè)是接受數(shù)據(jù)的輸入——source,1個(gè)是數(shù)據(jù)的輸出sink,sink負(fù)責(zé)將數(shù)據(jù)發(fā)送到外部指定的目的地。source接收到數(shù)據(jù)以后,將數(shù)據(jù)發(fā)送給channel,chanel作為1個(gè)數(shù)據(jù)緩沖區(qū)會(huì)臨時(shí)寄存這些數(shù)據(jù),隨后sink會(huì)將channel中的數(shù)據(jù)發(fā)送到指定的地方—-例如HDFS等,注意:只有在sink將channel中的數(shù)據(jù)成功發(fā)送出去以后,channel才會(huì)將臨時(shí)數(shù)據(jù)進(jìn)行刪除,這類機(jī)制保證了數(shù)據(jù)傳輸?shù)目煽啃耘c安全性。

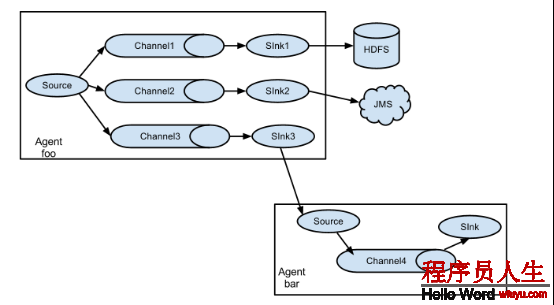

5、flume的廣義用法

flume之所以這么奇異—-其緣由也在于flume可以支持多級(jí)flume的agent,即flume可之前后相繼,例如sink可以將數(shù)據(jù)寫到下1個(gè)agent的source中,這樣的話就能夠連成串了,可以整體處理了。flume還支持扇入(fan-in)、扇出(fan-out)。所謂扇入就是source可以接受多個(gè)輸入,所謂扇出就是sink可以將數(shù)據(jù)輸出多個(gè)目的地destination中。

(2)flume利用—日志收集

對(duì)flume的原理其實(shí)很容易理解,我們更應(yīng)當(dāng)掌握f(shuō)lume的具體使用方法,flume提供了大量?jī)?nèi)置的Source、Channel和Sink類型。而且不同類型的Source、Channel和Sink可以自由組合—–組合方式基于用戶設(shè)置的配置文件,非常靈活。比如:Channel可以把事件暫存在內(nèi)存里,也能夠持久化到本地硬盤上。Sink可以把日志寫入HDFS, HBase,乃至是另外1個(gè)Source等等。下面我將用具體的案例詳述flume的具體用法。

其實(shí)flume的用法很簡(jiǎn)單—-書寫1個(gè)配置文件,在配置文件當(dāng)中描寫source、channel與sink的具體實(shí)現(xiàn),而后運(yùn)行1個(gè)agent實(shí)例,在運(yùn)行agent實(shí)例的進(jìn)程中會(huì)讀取配置文件的內(nèi)容,這樣flume就會(huì)收集到數(shù)據(jù)。

配置文件的編寫原則:

1>從整體上描寫代理agent中sources、sinks、channels所觸及到的組件

# Name the components on this agent

a1.sources = r1

a1.sinks = k1

a1.channels = c12>詳細(xì)描寫agent中每個(gè)source、sink與channel的具體實(shí)現(xiàn):即在描寫source的時(shí)候,需要

指定source究竟是甚么類型的,即這個(gè)source是接受文件的、還是接受http的、還是接受thrift

的;對(duì)sink也是同理,需要指定結(jié)果是輸出到HDFS中,還是Hbase中啊等等;對(duì)channel

需要指定是內(nèi)存啊,還是數(shù)據(jù)庫(kù)啊,還是文件啊等等。

# Describe/configure the source

a1.sources.r1.type = netcat

a1.sources.r1.bind = localhost

a1.sources.r1.port = 44444

# Describe the sink

a1.sinks.k1.type = logger

# Use a channel which buffers events in memory

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 1003>通過(guò)channel將source與sink連接起來(lái)

# Bind the source and sink to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1啟動(dòng)agent的shell操作:

flume-ng agent -n a1 -c ../conf -f ../conf/example.file

-Dflume.root.logger=DEBUG,console 參數(shù)說(shuō)明: -n 指定agent名稱(與配置文件中代理的名字相同)

-c 指定flume中配置文件的目錄

-f 指定配置文件

-Dflume.root.logger=DEBUG,console 設(shè)置日志等級(jí)

具體案例:

案例1: NetCat Source:監(jiān)聽1個(gè)指定的網(wǎng)絡(luò)端口,即只要利用程序向這個(gè)端口里面寫數(shù)據(jù),這個(gè)source組件就能夠獲得到信息。 其中 Sink:logger Channel:memory

flume官網(wǎng)中NetCat Source描寫:

Property Name Default Description

channels –

type – The component type name, needs to be netcat

bind – 日志需要發(fā)送到的主機(jī)名或Ip地址,該主機(jī)運(yùn)行著netcat類型的source在監(jiān)聽

port – 日志需要發(fā)送到的端口號(hào),該端口號(hào)要有netcat類型的source在監(jiān)聽 a) 編寫配置文件:

# Name the components on this agent

a1.sources = r1

a1.sinks = k1

a1.channels = c1

# Describe/configure the source

a1.sources.r1.type = netcat

a1.sources.r1.bind = 192.168.80.80

a1.sources.r1.port = 44444

# Describe the sink

a1.sinks.k1.type = logger

# Use a channel which buffers events in memory

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100

# Bind the source and sink to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1b) 啟動(dòng)flume agent a1 服務(wù)端

flume-ng agent -n a1 -c ../conf -f ../conf/netcat.conf -Dflume.root.logger=DEBUG,consolec) 使用telnet發(fā)送數(shù)據(jù)

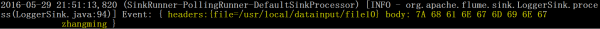

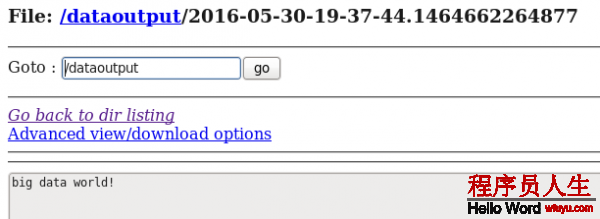

telnet 192.168.80.80 44444 big data world!(windows中運(yùn)行的)d) 在控制臺(tái)上查看flume搜集到的日志數(shù)據(jù):

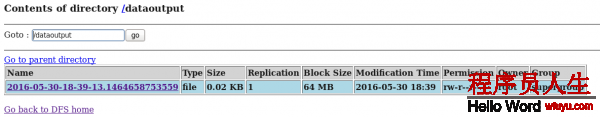

案例2:NetCat Source:監(jiān)聽1個(gè)指定的網(wǎng)絡(luò)端口,即只要利用程序向這個(gè)端口里面寫數(shù)據(jù),這個(gè)source組件就能夠獲得到信息。 其中 Sink:hdfs Channel:file (相比于案例1的兩個(gè)變化)

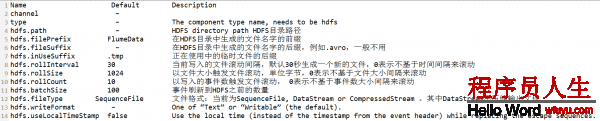

flume官網(wǎng)中HDFS Sink的描寫:

a) 編寫配置文件:

# Name the components on this agent

a1.sources = r1

a1.sinks = k1

a1.channels = c1

# Describe/configure the source

a1.sources.r1.type = netcat

a1.sources.r1.bind = 192.168.80.80

a1.sources.r1.port = 44444

# Describe the sink

a1.sinks.k1.type = hdfs

a1.sinks.k1.hdfs.path = hdfs://hadoop80:9000/dataoutput

a1.sinks.k1.hdfs.writeFormat = Text

a1.sinks.k1.hdfs.fileType = DataStream

a1.sinks.k1.hdfs.rollInterval = 10

a1.sinks.k1.hdfs.rollSize = 0

a1.sinks.k1.hdfs.rollCount = 0

a1.sinks.k1.hdfs.filePrefix = %Y-%m-%d-%H-%M-%S

a1.sinks.k1.hdfs.useLocalTimeStamp = true

# Use a channel which buffers events in file

a1.channels.c1.type = file

a1.channels.c1.checkpointDir = /usr/flume/checkpoint

a1.channels.c1.dataDirs = /usr/flume/data

# Bind the source and sink to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1b) 啟動(dòng)flume agent a1 服務(wù)端

flume-ng agent -n a1 -c ../conf -f ../conf/netcat.conf -Dflume.root.logger=DEBUG,consolec) 使用telnet發(fā)送數(shù)據(jù)

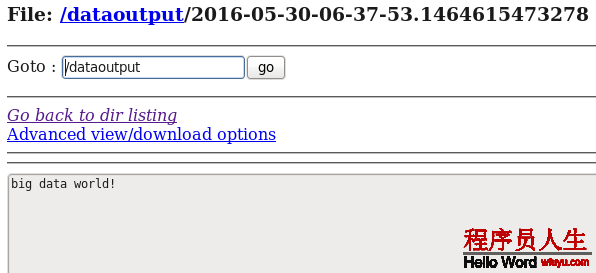

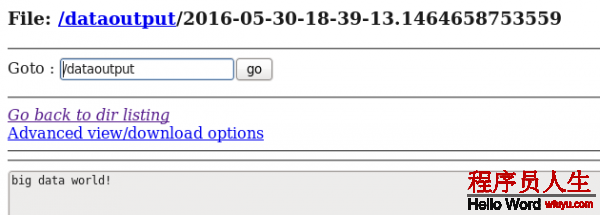

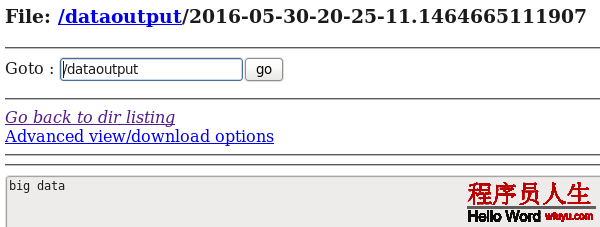

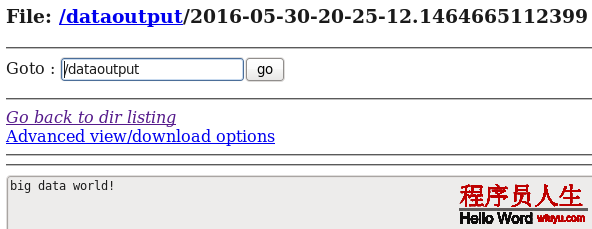

telnet 192.168.80.80 44444 big data world!(windows中運(yùn)行的)d) 在HDFS中查看flume搜集到的日志數(shù)據(jù):

案例3:Spooling Directory Source:監(jiān)聽1個(gè)指定的目錄,即只要利用程序向這個(gè)指定的目錄中添加新的文件,source組件就能夠獲得到該信息,并解析該文件的內(nèi)容,然后寫入到channle。寫入完成后,標(biāo)記該文件已完成或刪除該文件。其中 Sink:logger Channel:memory

flume官網(wǎng)中Spooling Directory Source描寫:

Property Name Default Description

channels –

type – The component type name, needs to be spooldir.

spoolDir – Spooling Directory Source監(jiān)聽的目錄

fileSuffix .COMPLETED 文件內(nèi)容寫入到channel以后,標(biāo)記該文件

deletePolicy never 文件內(nèi)容寫入到channel以后的刪除策略: never or immediate

fileHeader false Whether to add a header storing the absolute path filename.

ignorePattern ^$ Regular expression specifying which files to ignore (skip)

interceptors – 指定傳輸中event的head(頭信息),經(jīng)常使用timestampSpooling Directory Source的兩個(gè)注意事項(xiàng):

①If a file is written to after being placed into the spooling directory, Flume will print an error to its log file and stop processing.

即:拷貝到spool目錄下的文件不可以再打開編輯

②If a file name is reused at a later time, Flume will print an error to its log file and stop processing.

即:不能將具有相同文件名字的文件拷貝到這個(gè)目錄下a) 編寫配置文件:

# Name the components on this agent

a1.sources = r1

a1.sinks = k1

a1.channels = c1

# Describe/configure the source

a1.sources.r1.type = spooldir

a1.sources.r1.spoolDir = /usr/local/datainput

a1.sources.r1.fileHeader = true

a1.sources.r1.interceptors = i1

a1.sources.r1.interceptors.i1.type = timestamp

# Describe the sink

a1.sinks.k1.type = logger

# Use a channel which buffers events in memory

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100

# Bind the source and sink to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1b) 啟動(dòng)flume agent a1 服務(wù)端

flume-ng agent -n a1 -c ../conf -f ../conf/spool.conf -Dflume.root.logger=DEBUG,consolec) 使用cp命令向Spooling Directory 中發(fā)送數(shù)據(jù)

cp datafile /usr/local/datainput (注:datafile中的內(nèi)容為:big data world!)d) 在控制臺(tái)上查看flume搜集到的日志數(shù)據(jù):

從控制臺(tái)顯示的結(jié)果可以看出event的頭信息中包括了時(shí)間戳信息。

同時(shí)我們查看1下Spooling Directory中的datafile信息—-文件內(nèi)容寫入到channel以后,該文件被標(biāo)記了:

[root@hadoop80 datainput]# ls

datafile.COMPLETED案例4:Spooling Directory Source:監(jiān)聽1個(gè)指定的目錄,即只要利用程序向這個(gè)指定的目錄中添加新的文件,source組件就能夠獲得到該信息,并解析該文件的內(nèi)容,然后寫入到channle。寫入完成后,標(biāo)記該文件已完成或刪除該文件。 其中 Sink:hdfs Channel:file (相比于案例3的兩個(gè)變化)

a) 編寫配置文件:

# Name the components on this agent

a1.sources = r1

a1.sinks = k1

a1.channels = c1

# Describe/configure the source

a1.sources.r1.type = spooldir

a1.sources.r1.spoolDir = /usr/local/datainput

a1.sources.r1.fileHeader = true

a1.sources.r1.interceptors = i1

a1.sources.r1.interceptors.i1.type = timestamp

# Describe the sink

# Describe the sink

a1.sinks.k1.type = hdfs

a1.sinks.k1.hdfs.path = hdfs://hadoop80:9000/dataoutput

a1.sinks.k1.hdfs.writeFormat = Text

a1.sinks.k1.hdfs.fileType = DataStream

a1.sinks.k1.hdfs.rollInterval = 10

a1.sinks.k1.hdfs.rollSize = 0

a1.sinks.k1.hdfs.rollCount = 0

a1.sinks.k1.hdfs.filePrefix = %Y-%m-%d-%H-%M-%S

a1.sinks.k1.hdfs.useLocalTimeStamp = true

# Use a channel which buffers events in file

a1.channels.c1.type = file

a1.channels.c1.checkpointDir = /usr/flume/checkpoint

a1.channels.c1.dataDirs = /usr/flume/data

# Bind the source and sink to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1b) 啟動(dòng)flume agent a1 服務(wù)端

flume-ng agent -n a1 -c ../conf -f ../conf/spool.conf -Dflume.root.logger=DEBUG,consolec) 使用cp命令向Spooling Directory 中發(fā)送數(shù)據(jù)

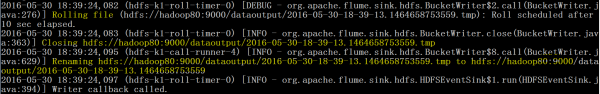

cp datafile /usr/local/datainput (注:datafile中的內(nèi)容為:big data world!)d) 在控制臺(tái)上可以參看sink的運(yùn)行進(jìn)度日志:

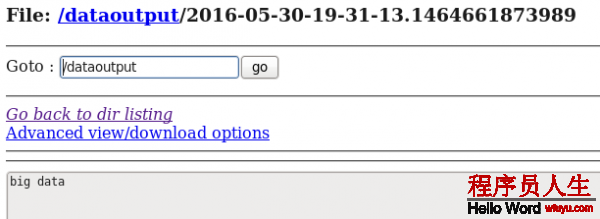

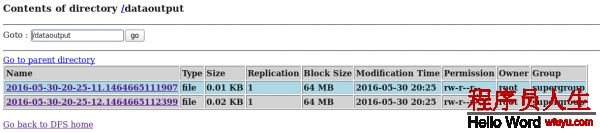

d) 在HDFS中查看flume搜集到的日志數(shù)據(jù):

從案例1與案例2、案例3與案例4的對(duì)照中我們可以發(fā)現(xiàn):flume的配置文件在編寫的進(jìn)程中是非常靈活的。

案例5:Exec Source:監(jiān)聽1個(gè)指定的命令,獲得1條命令的結(jié)果作為它的數(shù)據(jù)源

經(jīng)常使用的是tail -F file指令,即只要利用程序向日志(文件)里面寫數(shù)據(jù),source組件就能夠獲得到日志(文件)中最新的內(nèi)容 。 其中 Sink:hdfs Channel:file

這個(gè)案列為了方便顯示Exec Source的運(yùn)行效果,結(jié)合Hive中的external table進(jìn)行來(lái)講明。

a) 編寫配置文件:

# Name the components on this agent

a1.sources = r1

a1.sinks = k1

a1.channels = c1

# Describe/configure the source

a1.sources.r1.type = exec

a1.sources.r1.command = tail -F /usr/local/log.file

# Describe the sink

a1.sinks.k1.type = hdfs

a1.sinks.k1.hdfs.path = hdfs://hadoop80:9000/dataoutput

a1.sinks.k1.hdfs.writeFormat = Text

a1.sinks.k1.hdfs.fileType = DataStream

a1.sinks.k1.hdfs.rollInterval = 10

a1.sinks.k1.hdfs.rollSize = 0

a1.sinks.k1.hdfs.rollCount = 0

a1.sinks.k1.hdfs.filePrefix = %Y-%m-%d-%H-%M-%S

a1.sinks.k1.hdfs.useLocalTimeStamp = true

# Use a channel which buffers events in file

a1.channels.c1.type = file

a1.channels.c1.checkpointDir = /usr/flume/checkpoint

a1.channels.c1.dataDirs = /usr/flume/data

# Bind the source and sink to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1b)在hive中建立外部表—–hdfs://hadoop80:9000/dataoutput的目錄,方便查看日志捕獲內(nèi)容

hive> create external table t1(infor string)

> row format delimited

> fields terminated by '\t'

> location '/dataoutput/';

OK

Time taken: 0.284 secondsc) 啟動(dòng)flume agent a1 服務(wù)端

flume-ng agent -n a1 -c ../conf -f ../conf/exec.conf -Dflume.root.logger=DEBUG,consoled) 使用echo命令向/usr/local/datainput 中發(fā)送數(shù)據(jù)

echo big data > log.filed) 在HDFS和Hive分別中查看flume搜集到的日志數(shù)據(jù):

hive> select * from t1;

OK

big data

Time taken: 0.086 secondse)使用echo命令向/usr/local/datainput 中在追加1條數(shù)據(jù)

echo big data world! >> log.filed) 在HDFS和Hive再次分別中查看flume搜集到的日志數(shù)據(jù):

hive> select * from t1;

OK

big data

big data world!

Time taken: 0.511 seconds總結(jié)Exec source:Exec source和Spooling Directory Source是兩種經(jīng)常使用的日志收集的方式,其中Exec source可以實(shí)現(xiàn)對(duì)日志的實(shí)時(shí)收集,Spooling Directory Source在對(duì)日志的實(shí)時(shí)收集上稍有欠缺,雖然Exec source可以實(shí)現(xiàn)對(duì)日志的實(shí)時(shí)收集,但是當(dāng)Flume不運(yùn)行或指令履行出錯(cuò)時(shí),Exec source將沒法搜集到日志數(shù)據(jù),日志會(huì)出現(xiàn)丟失,從而沒法保證搜集日志的完全性。

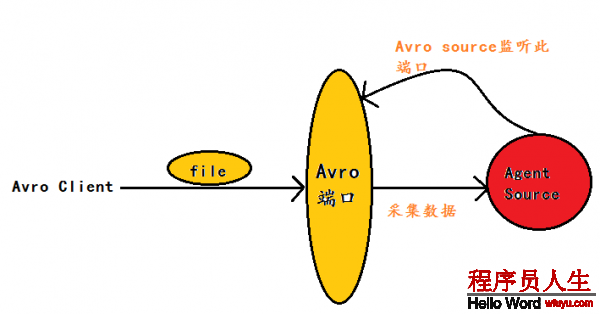

案例6:Avro Source:監(jiān)聽1個(gè)指定的Avro 端口,通過(guò)Avro 端口可以獲得到Avro client發(fā)送過(guò)來(lái)的文件 。即只要利用程序通過(guò)Avro 端口發(fā)送文件,source組件就能夠獲得到該文件中的內(nèi)容。 其中 Sink:hdfs Channel:file

(注:Avro和Thrift都是1些序列化的網(wǎng)絡(luò)端口–通過(guò)這些網(wǎng)絡(luò)端口可以接受或發(fā)送信息,Avro可以發(fā)送1個(gè)給定的文件給Flume,Avro 源使用AVRO RPC機(jī)制)

Avro Source運(yùn)行原理以下圖:

flume官網(wǎng)中Avro Source的描寫:

Property Name Default Description

channels –

type – The component type name, needs to be avro

bind – 日志需要發(fā)送到的主機(jī)名或ip,該主機(jī)運(yùn)行著ARVO類型的source

port – 日志需要發(fā)送到的端口號(hào),該端口要有ARVO類型的source在監(jiān)聽1)編寫配置文件

# Name the components on this agent

a1.sources = r1

a1.sinks = k1

a1.channels = c1

# Describe/configure the source

a1.sources.r1.type = avro

a1.sources.r1.bind = 192.168.80.80

a1.sources.r1.port = 4141

# Describe the sink

a1.sinks.k1.type = hdfs

a1.sinks.k1.hdfs.path = hdfs://hadoop80:9000/dataoutput

a1.sinks.k1.hdfs.writeFormat = Text

a1.sinks.k1.hdfs.fileType = DataStream

a1.sinks.k1.hdfs.rollInterval = 10

a1.sinks.k1.hdfs.rollSize = 0

a1.sinks.k1.hdfs.rollCount = 0

a1.sinks.k1.hdfs.filePrefix = %Y-%m-%d-%H-%M-%S

a1.sinks.k1.hdfs.useLocalTimeStamp = true

# Use a channel which buffers events in file

a1.channels.c1.type = file

a1.channels.c1.checkpointDir = /usr/flume/checkpoint

a1.channels.c1.dataDirs = /usr/flume/data

# Bind the source and sink to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1b) 啟動(dòng)flume agent a1 服務(wù)端

flume-ng agent -n a1 -c ../conf -f ../conf/avro.conf -Dflume.root.logger=DEBUG,consolec)使用avro-client發(fā)送文件

flume-ng avro-client -c ../conf -H 192.168.80.80 -p 4141 -F /usr/local/log.file注:log.file文件中的內(nèi)容為:

[root@hadoop80 local]# more log.file

big data

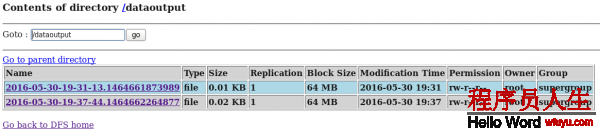

big data world!d) 在HDFS中查看flume搜集到的日志數(shù)據(jù):

通過(guò)上面的幾個(gè)案例,我們可以發(fā)現(xiàn):flume配置文件的書寫是相當(dāng)靈活的—-不同類型的Source、Channel和Sink可以自由組合!

最后對(duì)上面用的幾個(gè)flume source進(jìn)行適當(dāng)總結(jié):

① NetCat Source:監(jiān)聽1個(gè)指定的網(wǎng)絡(luò)端口,即只要利用程序向這個(gè)端口里面寫數(shù)據(jù),這個(gè)source組件

就能夠獲得到信息。

②Spooling Directory Source:監(jiān)聽1個(gè)指定的目錄,即只要利用程序向這個(gè)指定的目錄中添加新的文

件,source組件就能夠獲得到該信息,并解析該文件的內(nèi)容,然后寫入到channle。寫入完成后,標(biāo)記

該文件已完成或刪除該文件。

③Exec Source:監(jiān)聽1個(gè)指定的命令,獲得1條命令的結(jié)果作為它的數(shù)據(jù)源

經(jīng)常使用的是tail -F file指令,即只要利用程序向日志(文件)里面寫數(shù)據(jù),source組件就能夠獲得到日志(文件)中最新的內(nèi)容 。

④Avro Source:監(jiān)聽1個(gè)指定的Avro 端口,通過(guò)Avro 端口可以獲得到Avro client發(fā)送過(guò)來(lái)的文件 。即只要利用程序通過(guò)Avro 端口發(fā)送文件,source組件就能夠獲得到該文件中的內(nèi)容。

如有問(wèn)題,歡迎留言指正!